文章插图

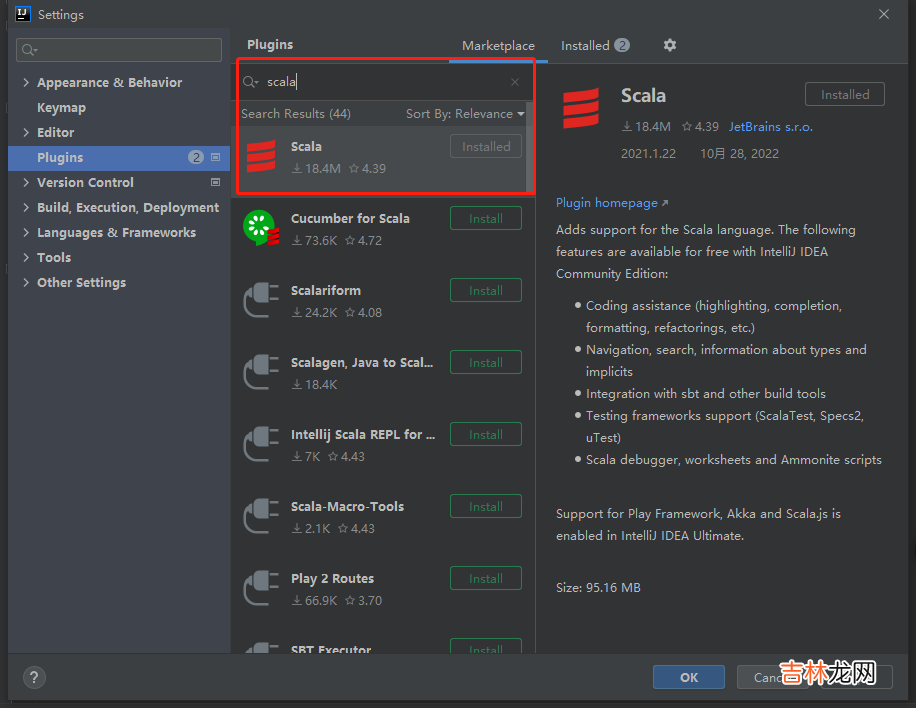

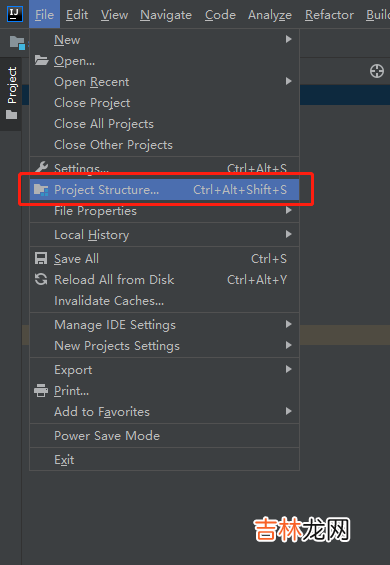

2. 给项目添加Global Libraries打开配置:

文章插图

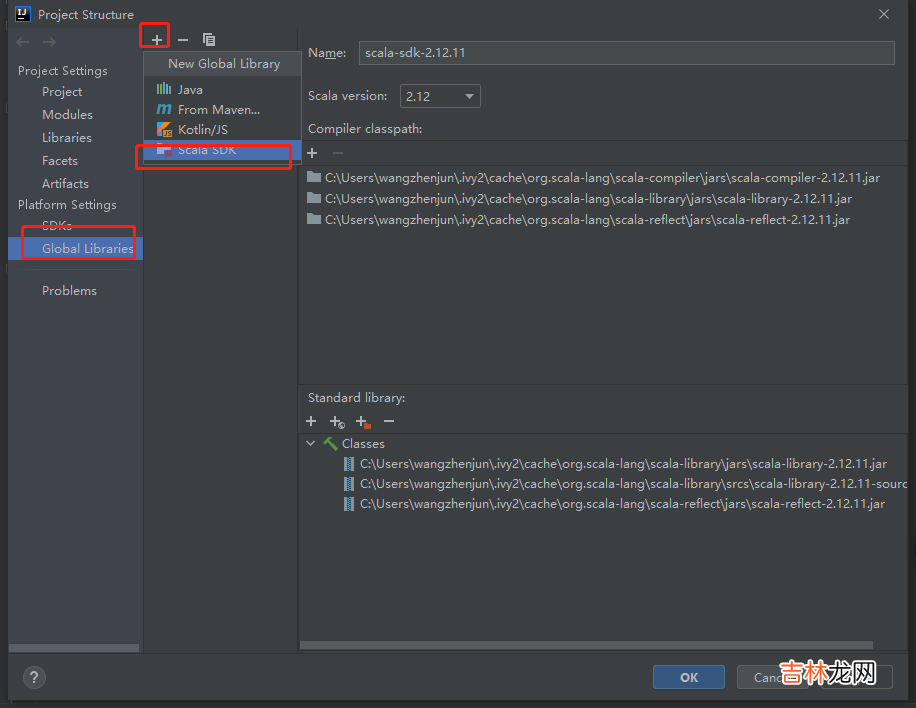

新增SDK

文章插图

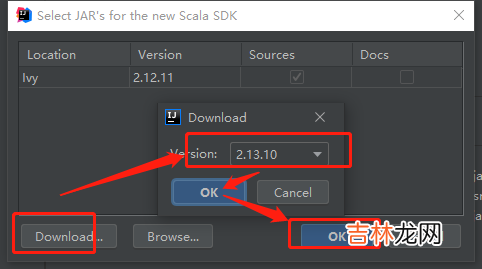

下载你需要的版本:小编这里是:

2.12.11

文章插图

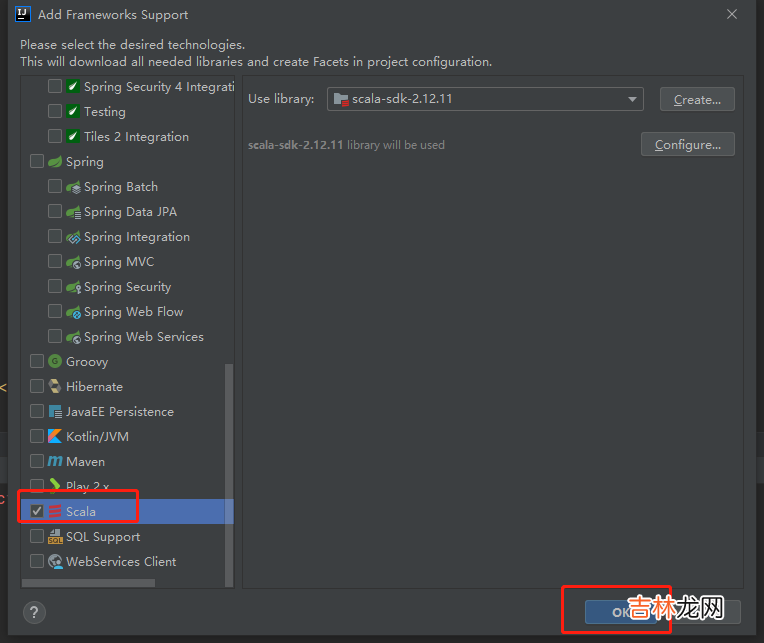

右击项目,添加上

scala:

文章插图

3. 导入依赖

<dependency><groupId>org.apache.spark</groupId><artifactId>spark-core_2.12</artifactId><version>3.0.0</version></dependency>4. 第一个程序

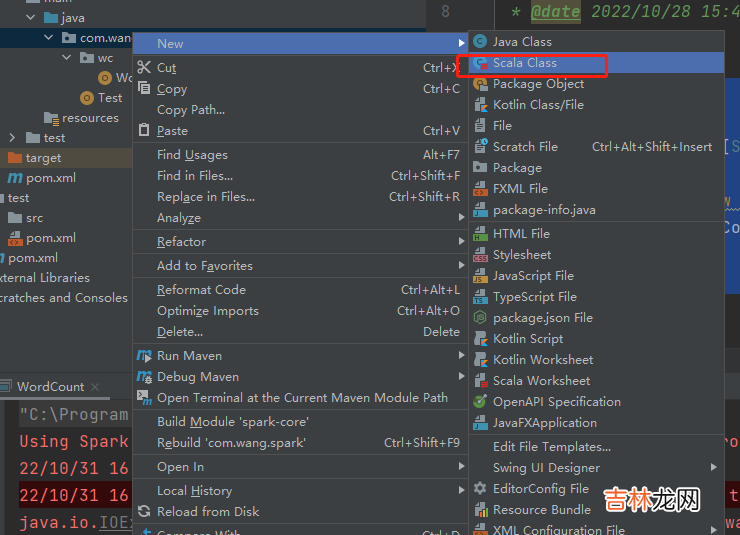

文章插图

文章插图

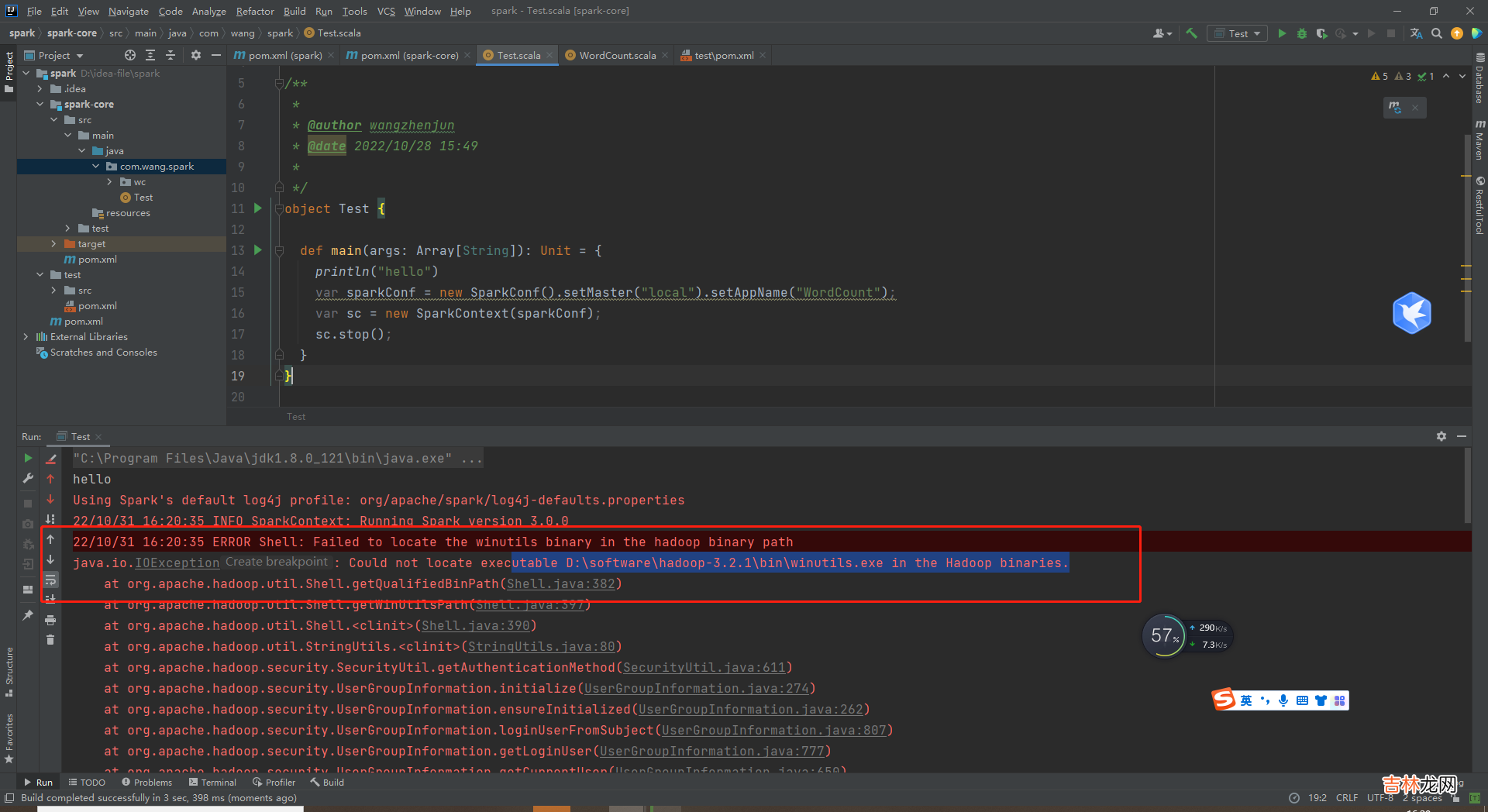

object Test {def main(args: Array[String]): Unit = {println("hello")var sparkConf = new SparkConf().setMaster("local").setAppName("WordCount");var sc = new SparkContext(sparkConf);sc.stop();}}5. 测试bug1Using Spark's default log4j profile: org/apache/spark/log4j-defaults.properties22/10/31 16:20:35 INFO SparkContext: Running Spark version 3.0.022/10/31 16:20:35 ERROR Shell: Failed to locate the winutils binary in the hadoop binary pathjava.io.IOException: Could not locate executable D:\software\hadoop-3.2.1\bin\winutils.exe in the Hadoop binaries.

文章插图

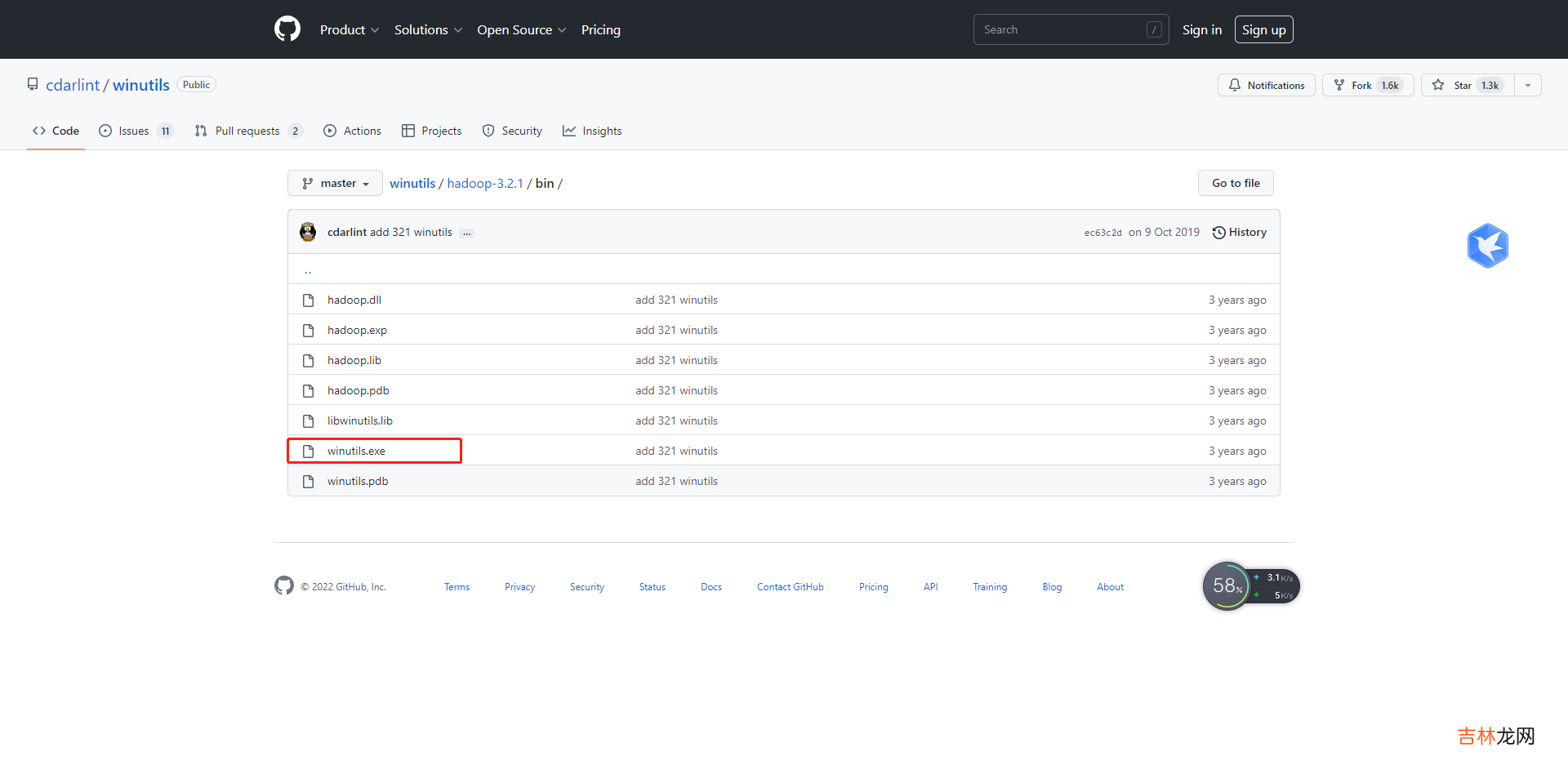

原因就是缺少:

winutils下载地址

文章插图

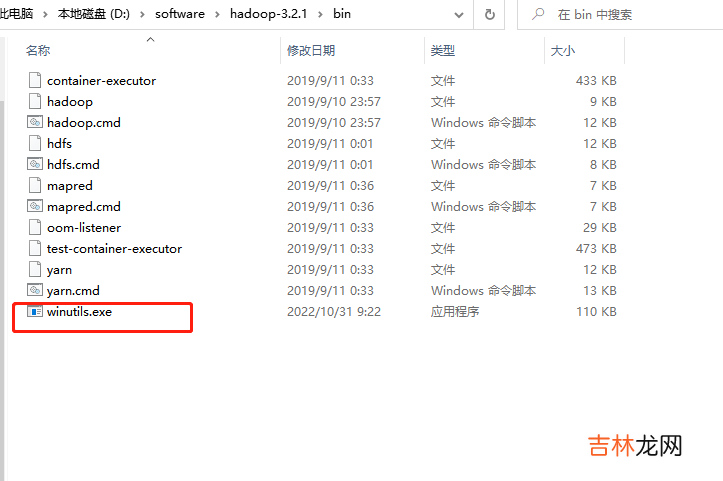

把它发放

Hadoop的bin目录下:

文章插图

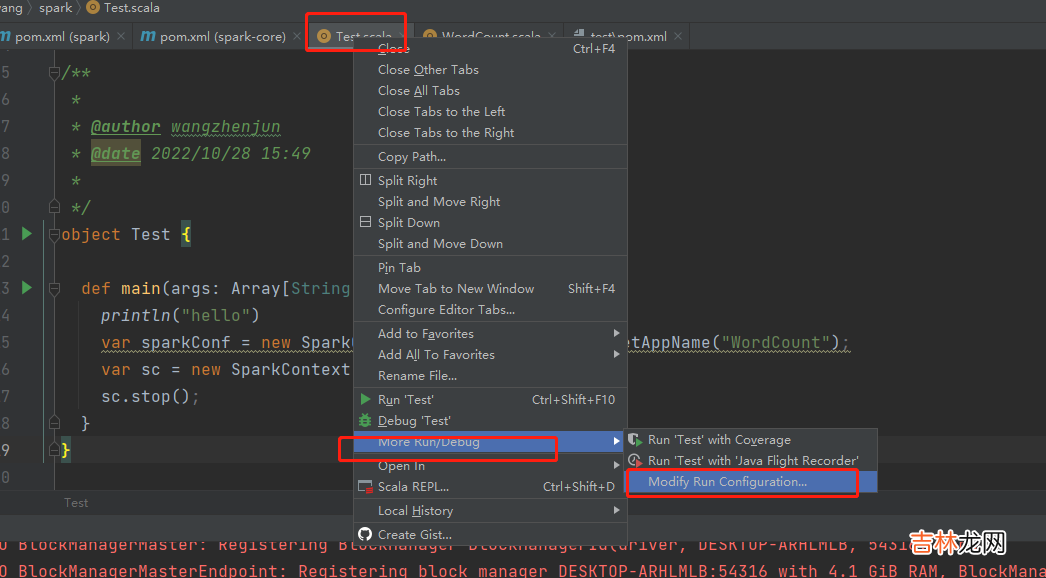

6. 测试bug2这个没办法复现,拔的网上的记录:

Using Spark's default log4j profile: org/apache/spark/log4j-defaults.properties22/10/08 21:02:10 INFO SparkContext: Running Spark version 3.0.022/10/08 21:02:10 ERROR SparkContext: Error initializing SparkContext.org.apache.spark.SparkException: A master URL must be set in your configuration at org.apache.spark.SparkContext.<init>(SparkContext.scala:380) at org.apache.spark.SparkContext.<init>(SparkContext.scala:120) at test.wyh.wordcount.TestWordCount$.main(TestWordCount.scala:10) at test.wyh.wordcount.TestWordCount.main(TestWordCount.scala)就是这句:A master URL must be set in your configuration解决方案:就是没有用到本地的地址

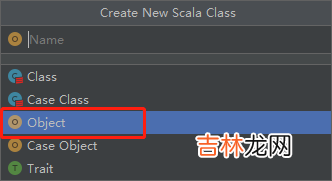

右击项目:

文章插图

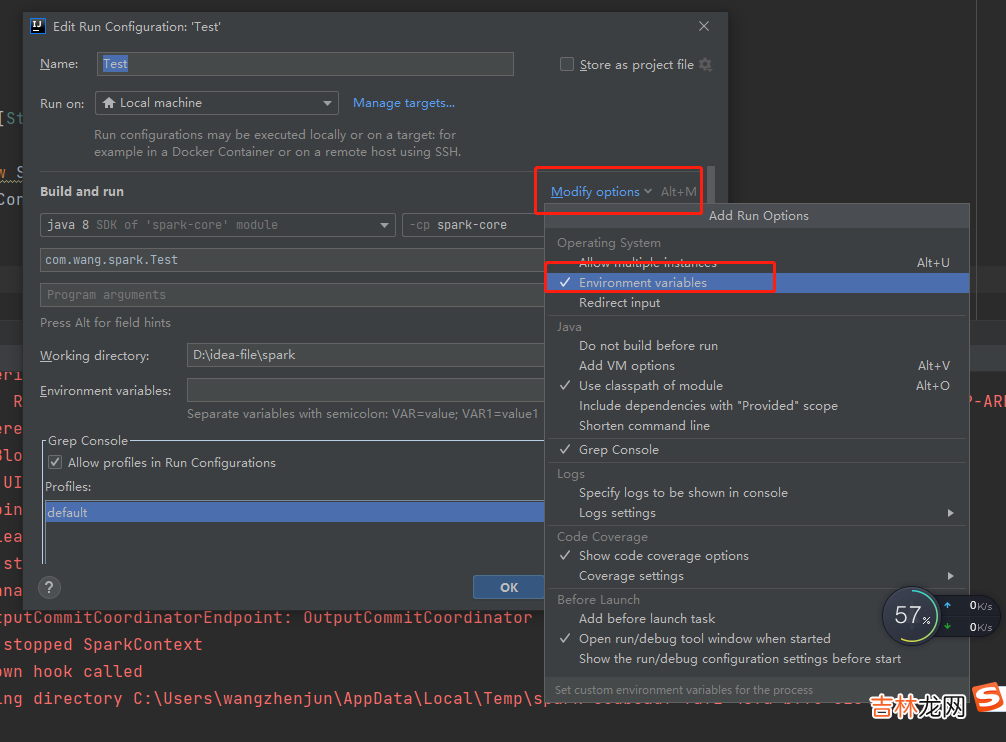

没有环境就添加上:

文章插图

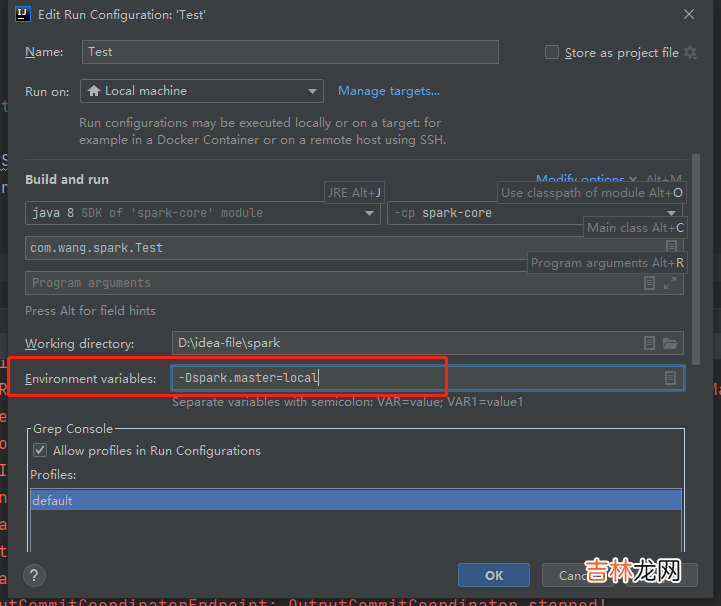

添加上:

-Dspark.master=local

文章插图

7. 测试完成没有error,完美!!

文章插图

五、总结这样就完成了,历尽千辛万苦,终于成功 。第一次结束差点劝退,发现自己对这个东西还是不懂,后面再慢慢补

Scala 。先上手感受,然后再深度学习!!如果对你有用,还请点赞关注下,支持一下一直是小编写作的动力!!

可以看下一小编的微信公众号,和网站文章首发看,欢迎关注,一起交流哈!!微信搜索:小王博客基地

文章插图

点击访问!小编自己的网站,里面也是有很多好的文章哦!

经验总结扩展阅读

- 王姓简单大气女孩名字 王姓诗经中最唯美的名字

- 简单顺口好记的金姓女生名字大全集 简单的名字大全

- OPPOReno6Z搭载什么处理器_OPPOReno6Z处理器介绍

- 云电视功能介绍 人脸识别的年代已到来

- 怎么画羊简笔画四年级(画一个最简单的羊)

- 水果店名称大全简单大气 有创意的水果店铺名字200个

- ?《偷偷藏不住》追剧日历 《偷偷藏不住》剧情介绍

- OPPOA93有哪些优缺点_OPPOA93优缺点介绍

- 简笔画如何画漫画羊(简笔画羊的画法大全简单)

- 简单的绵羊怎么画(如何画简单的绵羊)