Apache Hadoop是一个开源的分布式计算框架,用于处理大规模数据集的并行处理 。它采用了分布式文件系统HDFS和MapReduce计算模型 。Hadoop的设计目标是可靠性、可扩展性和高效性 。

HDFS是Hadoop的文件系统,它把大规模数据集分割成多个数据块,并在多个计算节点上进行存储 。这样可以实现数据的冗余存储和高可靠性 。HDFS还具有高吞吐量和低延迟的特点 , 适合处理大型数据集 。

【hadoop什么意思】MapReduce是Hadoop的计算模型,它通过将任务分解成多个分布式计算任务,然后将结果合并,实现并行计算 。MapReduce的优势在于可以在多台计算机上同时进行计算 , 提高了计算速度和可靠性 。

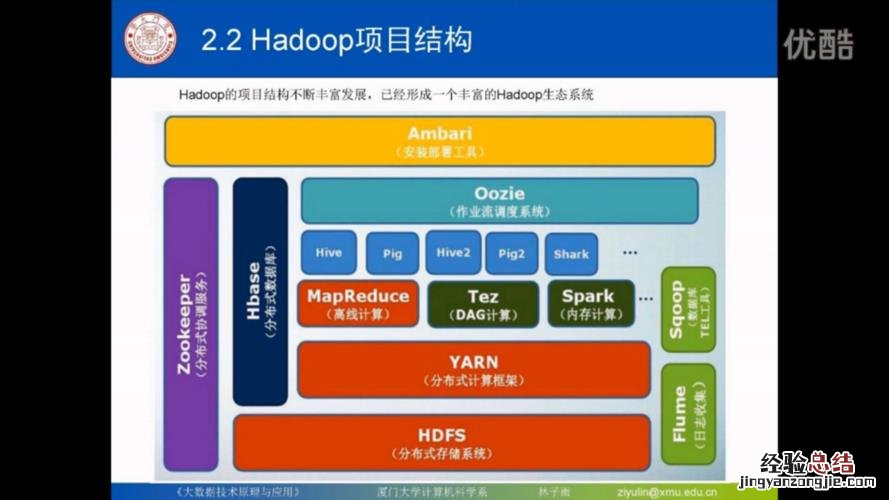

Hadoop生态系统包含了许多其他工具和框架,如Hive、HBase和Spark等 。这些工具提供了更高层次的抽象,使得开发人员可以更方便地进行大数据处理和分析 。