Client

包含访问HBase的接口并维护cache来加快对HBase的访问Zookeeper

保证任何时候,集群中只有一个masterMaster

存贮所有Region的寻址入口 。

实时监控Region server的上线和下线信息 。并实时通知Master

【1/5 HBase】存储HBase的schema和table元数据

为Region server分配regionRegionServer

负责Region server的负载均衡

发现失效的Region server并重新分配其上的region

管理用户对table的增删改操作

Region server维护region,处理对这些region的IO请求HLog(WAL log):

Region server负责切分在运行过程中变得过大的region

HLog文件就是一个普通的Hadoop Sequence File,Sequence File 的Key是 HLogKey对象,HLogKey中记录了写入数据的归属信息,除了table和 region名字外,同时还包括sequence number和timestamp,timestamp是” 写入时间”,sequence number的起始值为0,或者是最近一次存入文件系 统sequence number 。Region

HLog SequeceFile的Value是HBase的KeyValue对象,即对应HFile中的 KeyValue

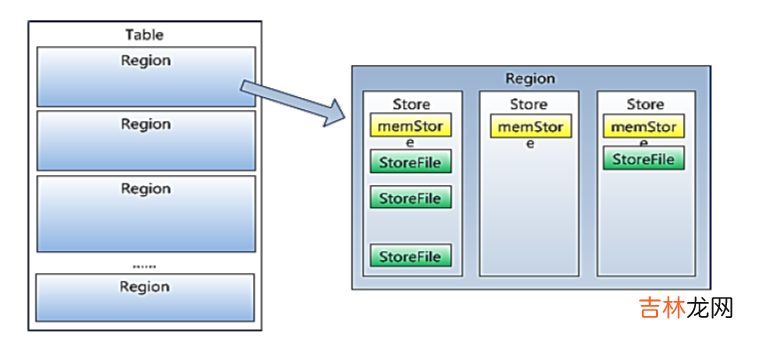

HBase自动把表水平划分成多个区域(region),每个region会保存一个表里面某段连续的数据;每个表一开始只有一个region,随着数据不断插 入表,region不断增大,当增大到一个阀值的时候,region就会等分会两个新的region(裂变);Memstore 与 storefile

当table中的行不断增多,就会有越来越多的region 。这样一张完整的表被保存在多个Regionserver上 。

如图:StoreFile 以HFile格式保存在HDFS上 。

- 一个region由多个store组成,一个store对应一个CF(列簇)

- store包括位于内存中的memstore和位于磁盘的storefile写操作先写入 memstore,当memstore中的数据达到某个阈值,hregionserver会启动 flashcache进程写入storefile,每次写入形成单独的一个storefile

- 当storefile文件的数量增长到一定阈值后,系统会进行合并(minor、 major compaction),在合并过程中会进行版本合并和删除工作 (majar),形成更大的storefile 。

- 当一个region所有storefile的大小和超过一定阈值后,会把当前的region 分割为两个,并由hmaster分配到相应的regionserver服务器,实现负载均衡 。

- 客户端检索数据,先在memstore找,找不到再找storefile

- HRegion是HBase中分布式存储和负载均衡的最小单元 。最小单元就表 示不同的HRegion可以分布在不同的HRegion server上 。

- HRegion由一个或者多个Store组成,每个store保存一个columns family 。

- 每个Strore又由一个memStore和0至多个StoreFile组成 。

文章插图

文章插图

3.3 理解难点1、flush刷新在HDFS上呈现究竟是怎么刷新的呢??我们目前刚刚学习的时候,添加数据,都是一条一条的put进去,而我们在put的数据比较少(小于128M)的时候,我们put完去HDFS上并未查看到我们put的文件,这是因为数据还在内存中,也就是还在memStore中,所以要想在HDFS中查看到,我们必须手动刷新到磁盘中,这是将memStore的数据刷新到StoreFile中去,这样我们在HDFS中就可以查看到了 。2、为什么Hbase不可以使用像Mysql那样进行查询??首先,我们应该可以感受到,我们在插入的时候,每行数据,有多少列,列名叫什么完全是我们自己定义的,之所以不支持像MySql那样对列进行查询和操作,因为不确定列的个数和名称 。3、数据最后存在HDFS上的,HDFS不支持删改,为什么Hbase就可以呢??这里有个思想误区,的确,数据是以HFile形式存在HDFS上的,而且HDFS的确是不支持删改的,但是为什么Hbase就支持呢?首先,这里的删除并不是真正意义上的对数据进行删除,而是对数据进行打上标记,我们再去查的时,就不会查到这个打过标记的数据,这个数据Hmaster会每隔1小时清理 。修改是put两次,Hbase会取最新的数据,过期数据也是这个方式被清理 。