并新增一个函数def my_export_onnx():

def my_export_onnx(model, im, file, opset, train, dynamic, simplify, prefix=colorstr('ONNX:')): print('anchors:', model.yaml['anchors']) wtxt = open('class.names', 'w') for name in model.names: wtxt.write(name+'\n') wtxt.close() # YOLOv5 ONNX export print(im.shape) if not dynamic: f = os.path.splitext(file)[0] + '.onnx' torch.onnx.export(model, im, f, verbose=False, opset_version=12, input_names=['images'], output_names=['output']) else: f = os.path.splitext(file)[0] + '_dynamic.onnx' torch.onnx.export(model, im, f, verbose=False, opset_version=12, input_names=['images'], output_names=['output'], dynamic_axes={'images': {0: 'batch', 2: 'height', 3: 'width'}, # shape(1,3,640,640) 'output': {0: 'batch', 1: 'anchors'} # shape(1,25200,85) }) return f在cmd中输入转onnx的命令(记得将export.py和pt模型放在同一路径下):

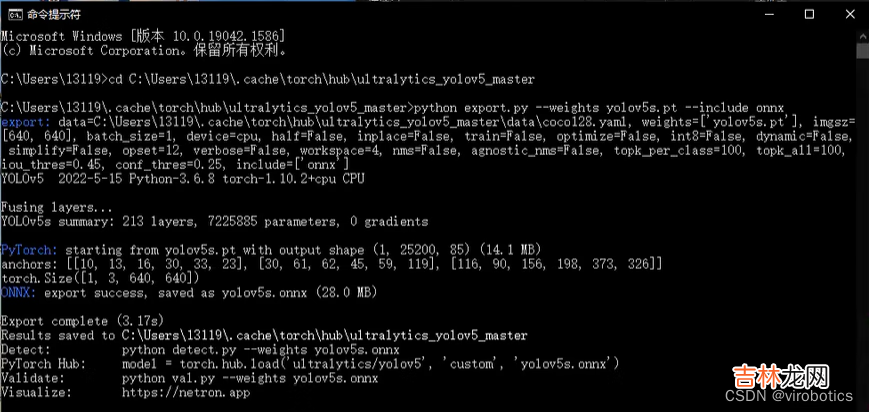

python export.py --weights yolov5s.pt --include onnx如下图所示为转化成功界面

文章插图

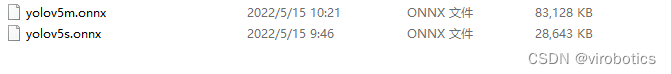

其中yolov5s可替换为yolov5m\yolov5m\yolov5l\yolov5x

文章插图

三、LabVIEW调用YOLOv5模型实现实时物体识别(yolov5_new_opencv.vi)本例中使用LabvVIEW工具包中opencv的dnn模块readNetFromONNX()载入onnx模型,可选择使用cuda进行推理加速 。

1.查看模型我们可以使用netron 查看yolov5m.onnx的网络结构,浏览器中输入链接:https://netron.app/,点击Open Model,打开相应的网络模型文件即可 。

文章插图

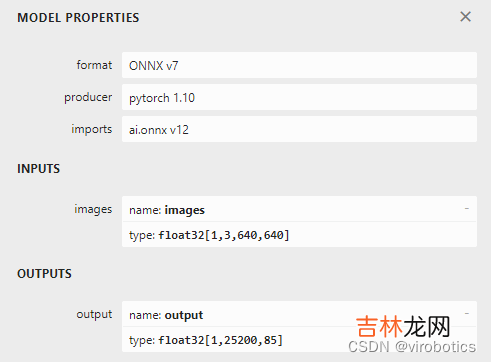

如下图所示是转换之后的yolov5m.onnx的属性:

文章插图

2.参数及输出blobFromImage参数: size:640*640 Scale=1/255 Means=[0,0,0]

Net.forward()输出: 单数组 25200*85

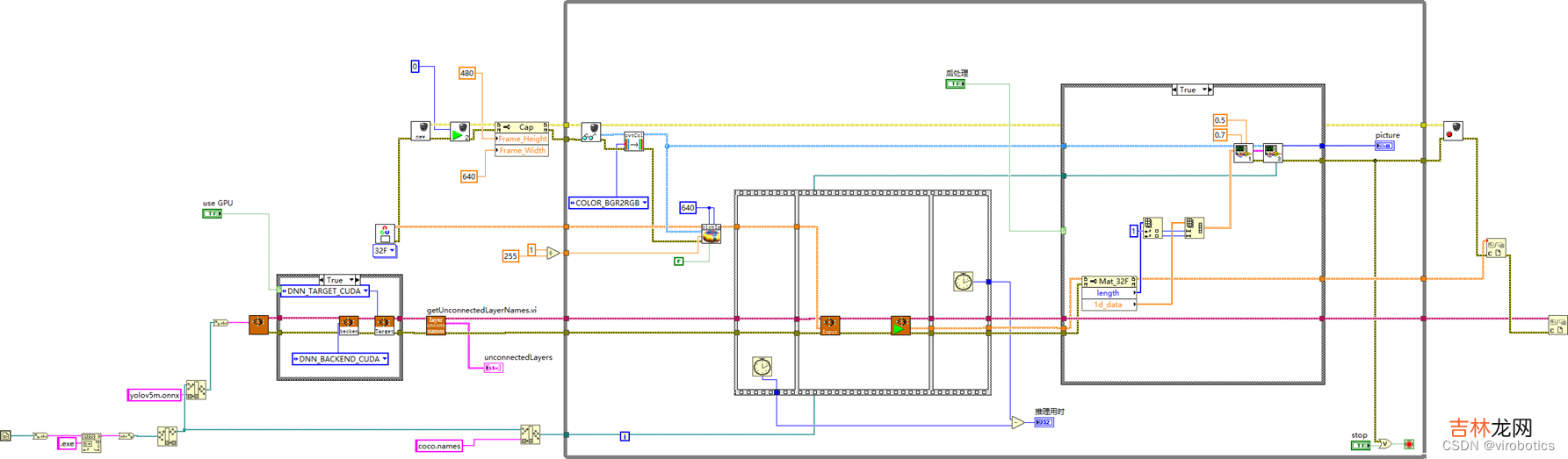

3.LabVIEW调用YOLOv5源码如下图所示,调用摄像头实现实时物体识别

文章插图

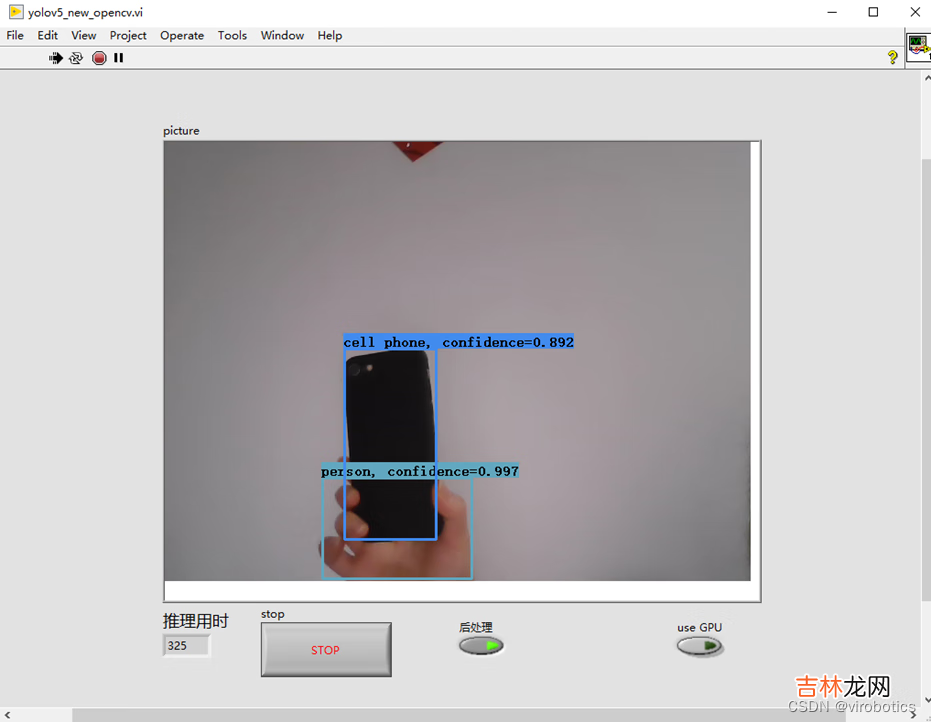

4.LabVIEW调用YOLOv5实时物体识别结果本次我们是以yolov5m.onnx为例来测试识别结果和速度的; 不使用GPU加速,仅在CPU模式下,实时检测推理用时在300ms/frame左右

经验总结扩展阅读

- 喷了杀虫剂可以开空调吗

- 木鱼花怎么吃

- 奥运会意义何在

- 一斤苦瓜泡多少酒

- 转化糖浆的作用与用途

- 20公里跑步要多久时间

- 爆炸盐可以放洗衣机洗衣服吗

- 高粱米和大米一起煮饭能熟吗

- 盐湖的盐能直接食用吗

- 证件照标准