我们将一个多集群的资源池规模按优先级描述为以下所示的三个维度:

- Num of Clusters: 集群数量是衡量一个多集群系统资源池规模和承载能力最直接且最重要的维度,在其余维度不变的情况下系统能接入的集群数量越多,说明系统的资源池规模越大,承载能力越强 。

- Num of Resources(API Objects): 对于一个多集群系统的控制面来说,存储并不是无限制的,而在控制面创建的资源对象的数量和总体大小受限于系统控制面的存储,也是制约多集群系统资源池规模的重要维度 。这里的资源对象不仅指下发到成员集群的资源模板,而且还包括集群的调度策略、多集群服务等资源 。

- Cluster Size: 集群规模是衡量一个多集群系统资源池规模不可忽视的维度 。一方面,集群数量相等的情况下,单个集群的规模越大,整个多集群系统的资源池越大 。另一方面,多集群系统的上层能力依赖系统对集群的资源画像,例如在多集群应用的调度过程中,集群资源是不可或缺的一个因素 。综上所述,单集群的规模与整个多集群系统息息相关,但单集群的规模同样不是制约多集群系统的限制因素 。用户可以通过优化原生的Kubernetes组件的方式来提升单集群的集群规模,达到扩大整个多集群系统的资源池的目的,但这不是衡量多集群系统性能的关注点 。本次测试中,社区参考了kubernetes的大规模集群的标准配置以及测试工具的性能,制定了测试集群的规模,以贴切实际生产环境中的单集群配置 。在集群的标准配置中,Node与Pod毫无疑问是其中最重要的两个资源,Node是计算、存储等资源的最小载体,而Pod数量则代表着一个集群的应用承载能力 。事实上,单集群的资源对象也包括像service,configmap,secret这样的常见资源 。这些变量的引入会使得测试过程变得更复杂,所以这次测试不会过多关注这些变量 。

- Num of Nodes

- Num of Pods

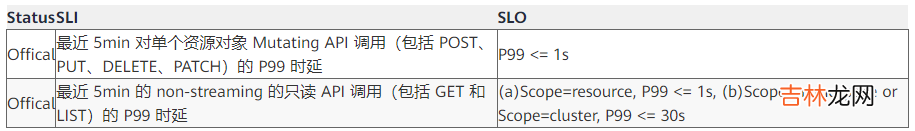

SLIs/SLOs可扩展性和性能是多集群联邦的重要特性 。作为多集群联邦的用户,我们期望在以上两方面有服务质量的保证 。在进行大规模性能测试之前,我们需要定义测量指标 。在参考了 Kubernetes 社区的 SLI(Service Level Indicator)/SLO(Service Level Objectives)和多集群的典型应用,Karmada 社区定义了以下 SLI/SLO 来衡量多集群联邦的服务质量 。

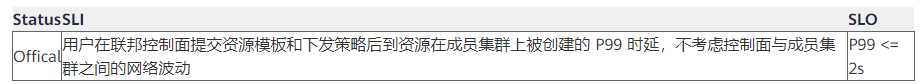

- API Call Latency

文章插图

- Resource Distribution Latency

文章插图

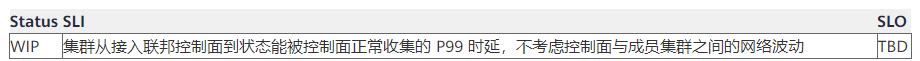

- Cluster Registration Latency

文章插图

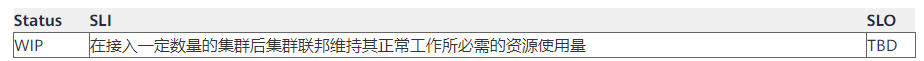

- Resource usage

文章插图

Note:

- 上述指标不考虑控制面和成员集群的网络波动 。同时,单集群内的 SLO 不会考虑在内 。

经验总结扩展阅读

- 免费店铺取名字大全 店铺名称评分测试打分免费

- 抖音外卖测试独立板块入口在哪

- 红魔6SPro游戏测试_红魔6SPro游戏表现

- 1分钟完成在线测试部署便捷收集班级同学文件的web管理系统

- 小米Civi续航怎么样_小米Civi续航测试

- 荣耀Magic3Pro续航测试_荣耀Magic3Pro续航怎么样

- 红米note10pro发热严重吗_红米note10pro发热测试

- 四 【单元测试】Junit 4--Junit4参数化

- 三 【单元测试】Junit 4--Junit4断言

- 二 【单元测试】Junit 4--eclipse配置Junit+Junit基础注解