1、Python爬虫是什么?网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间 , 更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本 。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫 。

其实通俗的讲就是通过程序去获取web页面上自己想要的数据,也就是自动抓取数据 。

爬虫可以做什么?

你可以用爬虫爬图片,爬取视频等等你想要爬取的数据,只要你能通过浏览器访问的数据都可以通过爬虫获取 。

爬虫的本质是什么?

模拟浏览器打开网页,获取网页中我们想要的那部分数据

浏览器打开网页的过程:

当你在浏览器中输入地址后 , 经过DNS服务器找到服务器主机,向服务器发送一个请求,服务器经过解析后发送给用户浏览器结果,包括html,js,css等文件内容,浏览器解析出来最后呈现给用户在浏览器上看到的结果 。

所以用户看到的浏览器的结果就是由HTML代码构成的,我们爬虫就是为了获取这些内容,通过分析和过滤html代码,从中获取我们想要资源 。

爬虫一般是指网络资源的抓取,由于Python的脚本特性,易于配置对字符的处理非常灵活 , Python有丰富的网络抓取模块,因此两者经常联系在一起Python就被叫作爬虫 。

Python爬虫的构架组成:

Python的工作流程则:

Python

就是一个程序,他把网页源代码下载下来,然后,用字符串提取的方式提取里面有效的信息,然后再把这个网页里的所有链接,再以同样的方式访问下载,然后再找里面的链接 。周而复始,这样就可以慢慢的像虫子一样爬满整个网络的网页信息了,简单说叫数据采集 。

爬虫又叫做网络爬虫,可以理解为蜘蛛在网络上进行爬行,互联网是一个巨大的网络,爬虫就是行走在网络上的爬虫,遇到自己喜欢的食物,就会抓取下来,抓取网络资源 。

而Python是最适合爬虫的语言,因为Python本身上就是一种比较简单的编程语言,适合零基础人员,更适合初学者学习,门槛低、功能强大;从实际情况上来说,爬虫是Python里面较为简单的课程 , 学习起来并不是非常困难的,简单的说,只要能在网络上看到的数据都是可以爬取的,大多数的爬虫都是通过发送请求-获取页面-解析页面-提取和存储内容来实现,实际就是用来获取网页的信息 。

为自动提取网页的程序,它为搜索引擎从zhi万维网上下载网页 。网络爬虫为一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成 。传统爬虫从一个或若干初始网页的URL开始 , 获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件 。将根据一定的搜索策略从队列中选择下一步要抓取的网页URL,并重复上述过程,直到达到系统的某一条件时停止 。另外,所有被爬虫抓取的网页将会被系统存贮,进行一定的分析、过滤,并建立索引,以便之后的查询和检索 。

文章插图

文章插图

2、Python为什么叫爬虫?Python爬虫的出现给许多网络工作者爬取信息提供非常大的便利,不但方便快捷还进一步提高了工作效率 。Python爬虫在网络采集信息的时候,经常会出现IP莫名其妙被禁的情况,爬取信息的工作不能接着进行,工作停滞不前 。

网络爬虫也叫网络机器人,是一种用于自动浏览因特网的程序或是脚本 。爬虫可以验证超链接和HTML代码 , 用于网络抓取 。网络搜索引擎等站点利用爬虫软件升级自身的网站内容或其对其他网站的索引 。他可以实现快捷采集信息、整理任务,起着节省时间的作用 。但是爬虫访问网站的过程会消耗目标系统资源,因而在访问大量页面时,爬虫需要充分考虑规划、负载等问题 。爬虫要是超过了网站所限制的访问次数,导致了网站的负荷,网站便会启动反爬虫机制防止爬虫接着毫无顾忌的爬取信心 。

当爬虫被禁的时候,先要找到被禁的原因,才可以对症下药 , 预防一错再错 。下边简要说说几种爬虫被禁的原因 。当网页出现空白,缺乏信息的情况,有很大很有可能网站创建页面的JavaScript出现问题 。当出现登录空白,不能保持登录状态情况下,可能需要检查一下cookie 。当页面打不开或是访问错误,就有可能使IP地址遭受网站封禁 。

Python与爬虫两者是分别独立的概念,Python是编程语言的一种,而爬虫程序只是因为大多使用Python语言编写而成,所以常常与Python一同出现 。

Python相对Java的优点

1.Python作为动态语言更适合编程初学者 。Python可以让初学者把精力集中在编程对象和思维方法上,而不用去担心语法、类型等等外在因素,并且Python清晰简洁的语法也使得它调试起来比Java简单的多 。

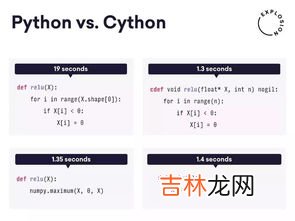

2.Python有一些Java没有的强大架构,可以使得爬虫程序更为高效平稳的运行 。

3.Python有非常强大的支持异步的框架如Eventlet Networking Library,而Java要实现这些功能要麻烦的多,也因此Python适合一些可扩展的后台应用 。(但除此以外Python可扩展性是不如Java的)

4.Python作为脚本语言,更适合开发体量稍小的应用,而且极其适合在应用发展初期时用来做原型 。

【python为什么叫爬虫,Python爬虫是什么?】因为python的脚本特性和易于配置,对字符的处理也非常灵活,加上python有丰富的网络抓取模块,所以叫爬虫 。

1、网络爬虫是指一种按照一定的规则,自动地抓取万维网信息的程序或者脚本,另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫,用python写一个搜索引擎,而搜索引擎就是一个复杂的爬虫 , 所以两者经常联系在一起 。

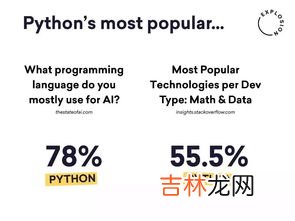

2、Python主要有四大主要应用,分别是网络爬虫、网站开发、人工智能、自动化运维,它是一种全栈的开发语言,如果你能学好Python,前端,后端 , 测试,大数据分析 , 爬虫等这些工作你都能胜任 。

3、随着网络的迅速发展 , 传统的通用搜索引擎AltaVista,Yahoo!和Google等辅助人们检索信息的工具成为用户访问万维网的入口和指南,但是这些通用性搜索引擎也存在着一定的局限性 , 为了解决这些问题,定向抓取相关网页资源的聚焦爬虫应运而生 。

“爬虫一般是指网络资源的抓取,由于Python的脚本特性,易于配置对字符的处理非常灵活,Python有丰富的网络抓取模块,因此两者经常联系在一起Python就被叫作爬虫 。爬虫可以抓取某个网站或者某个应用的内容提取有用的价值信息 。还可以模拟用户在浏览器或者app应用上的操作行为,实现程序…”

文章插图

文章插图

3、Python为什么叫爬虫?爬虫一般是指网络资源的抓?。蛭猵ython的脚本特性,python易于配置,对字符的处理也非常灵活,加上python有丰富的网络抓取模块,所以两者经常联系在一起 。简单的用python自己的urllib库也可以;用python写一个搜索引擎,而搜索引擎就是一个复杂的爬虫 。从这里你就了解了什么是Python爬虫,是基于Python编程而创造出来的一种网络资源的抓取方式,Python并不是爬虫 。

Python为什么适合些爬虫?

1)抓取网页本身的接口

相比与其他静态编程语言,如java , c#,C++,python抓取网页文档的接口更简洁;相比其他动态脚本语言,如perl,shell,python的urllib2包提供了较为完整的访问网页文档的API 。(当然ruby也是很好的选择)

此外 , 抓取网页有时候需要模拟浏览器的行为,很多网站对于生硬的爬虫抓取都是封杀的 。这是我们需要模拟user agent的行为构造合适的请求,譬如模拟用户登陆、模拟session/cookie的存储和设置 。在python里都有非常优秀的第三方包帮你搞定,如Requests,mechanize

2)网页抓取后的处理

抓取的网页通常需要处理,比如过滤html标签,提取文本等 。python的beautifulsoap提供了简洁的文档处理功能,能用极短的代码完成大部分文档的处理 。

其实以上功能很多语言和工具都能做,但是用python能够干得最快 , 最干净 。Life is short,u need python.

Python是大蟒蛇的释义

Python自带的urllib库 , 第三方的requests库和Scrappy框架让开发爬虫变得非常容易 。

很多人以为Python就是爬虫,爬虫就是Python 。其实,虽然两者的发音有点接近,但是它们并不是同一样东西 。

没有这个说法 , 只是广告效果打的比较好 , 为了卖课而把python和爬虫强行关联起来,如果真的要做爬虫,用一起工具可能会更简单一些 。比如八爪鱼,后羿,webscraper , 迷你派采集器等 , 至少不需要学那么多东西 。

Python不叫爬虫,谁告诉你Python叫爬虫的,爬虫是爬虫,Python是Python , 爬虫可以用Python写,也可以用别的语言写 。Python可以实现爬虫,也可以实现其它功能 。

爬虫一般是指网络资源的抓取 , 因为python的脚本特性,python易于配置,对字符的处理也非常灵活,加上python有丰富的网络抓取模块,所以两者经常联系在一起 。

文章插图

文章插图

4、python为什么叫爬虫python可以理解为在网络上爬行的一只蜘蛛,互联网就比作一张大网,而爬虫便是在这张网上爬来爬去的蜘蛛,如果它遇到自己的猎物(所需要的资源),那么就会将其抓取下来 。

比如它在抓取一个网页,在这个网中发现了一条道路,其实就是指向网页的超链接,那么它就可以爬到另一张网上来获取数据 。因为python的脚本特性,易于配置 , 对字符的处理也非常灵活,加上python有丰富的网络抓取模块,所以两者经常联系在一起 。

网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本 。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫 。

文章插图

文章插图

5、python为什么叫爬虫如果你在英文词典里边查Python,它会给出你Python是大蟒蛇的释义,那为什么现在有人会把python叫做爬虫呢?

Python是著名的GuidovanRossum在1989年编写的一个编程语言 。Python是一种计算机程序设计语言 。是一种动态的、面向对象的脚本语言 , 最初被设计用于编写自动化脚本,随着版本的不断更新和语言新功能的添加,越来越多被用于独立的、大型项目的开发 。

python为什么叫爬虫

爬虫一般是指网络资源的抓取,因为python的脚本特性 , python易于配置,对字符的处理也非常灵活 , 加上python有丰富的网络抓取模块,所以两者经常联系在一起 。简单的说用python写一个搜索引擎 , 而搜索引擎就是一个复杂的爬虫系统 。从这里你就了解了什么是Python爬虫,是基于Python编程而创造出来的一种网络资源的抓取方式,而不是Python就是爬虫 。

经验总结扩展阅读

- 什么是旗舰店,什么叫旗舰店?什么叫工厂店?

- 加菲猫为什么爱流眼泪,加菲猫流眼泪鼻涕

- 楚乔传为什么找林更新,赵丽颖林更新将再合作《楚乔传2》?男方回应:这事得问赵丽颖

- 十五 白真为什么总要找毕方,墨白之桃花浅渊感伤

- 为什么宫园薰没本子,宫园薰到底死没死?

- 为什么金毛幼犬爱咬人,我家金毛最近老是咬人,是什么原因?

- 补睫毛为什么要10天,补睫毛是不是卸了重新在种

- 可乐娜娜为什么吵架,娜娜和可乐是是哪个电视剧里面的人物

- 叶子菜为什么不能放冰箱里,绿叶蔬菜不适宜放在冰箱里储存,那么该如何保存呢?

- 为什么经期不能喝牛奶,来月经可以喝牛奶吗